稀疏表示+子空間學習 (ICCV2011)

http://blog.csdn.net/yihaizhiyan/article/details/7633658

解讀文獻:L. Zhang, P. Zhu, Q. Hu and D. Zhang, “A Linear Subspace Learning Approach via Sparse Coding,” in ICCV 2011.

線性子空間學習(Linear subspace learning,LSL),是通過線性投影,實現高維特徵空間到低維空間的對映~

原有方法的缺點:大多的線性子空間學習,是直接從原始訓練樣本中統計學習子空間~ 但是在計算機視覺中,不同元件貢獻也不同~~

現提出:利用稀疏表示和特徵分組----->子空間學習~

首先從訓練資料集中學習字典,以便用於稀疏的表示樣本~

字典中的影象元件,分了兩類,利於分辨和不利於分辨的部分 (More / Less discriminant part;MDP/LDP)~

無監督準則/有監督準則---->子空間學習。其中MDP保留,LDP抑制~

線性子空間學習方法,包括PCA、Eigenface、Fisher 線性判別式分析、基於LPP(locality preserving projection)流形學習、區域性判別式嵌入(local discriminant embedding LDE)、圖嵌入(graph embedding)。

根據是否利用訓練樣本的類別資訊,可分為無監督的方法(PCA、LPP)和有監督的方法(FLDA、regularized LDA、LDE)。

線性子空間學習的方法,是通過一種確定的判別函式,學習理想的子空間或者投影方式~

例如:PCA是尋找一種不相關(即是正交的)的最佳子空間。FLDA是通過最大化(類間方差/類內方差)比率,學習最佳子空間~

高維資料一般處於低維流形上,所以LSL(例如LPP)可以通過保留原始高位資料的幾何圖,學習子空間~

線性子空間學習中樣本方差矩陣計算的問題~ 不同元件有著不同的貢獻~ 例如:噪聲應有較小的貢獻~ 因此把影象分解為兩類不同的元件,一類貢獻比較大,一類貢獻比較小~

稀疏表示(用於壓縮、字典學習、影像元件分析)

首先從樣本集中基於patch的思想,學習一個字典D,有k個元素/元件。 然後把這k個元件分為兩類(MDP和LDP)。然後確定投影矩陣,投影之,進行分類~

本文方法的框架圖:

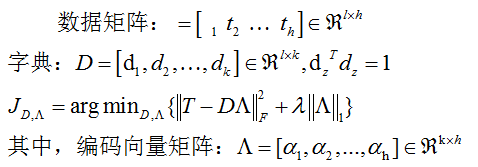

一、字典學習和稀疏編碼~

資料集有m個樣本x~ 每個樣本都分為兩個部分,MDP和LDP。

如果有一個測試樣本y,則直接利用P進行投影,計算Py和PX的距離,利用NN進行分類之~

利用稀疏表示學習字典D。因為原始影象維數比較高,很難直接學習一個冗餘字典。所以基於patch的思想進行學習之~

將每個訓練樣本分為q個重疊patch,最終由h=m*q的patch,其中m是樣本數。

二、無監督子空間學習

在經過稀疏編碼之後,每個影象被分解為k個特徵影象。

三、有監督子空間學習