Strong Baselines for Neural Semi-supervised Learning under Domain Shift半監督學習

2018 ACL 論文

Strong Baselines for Neural Semi-supervised Learning under Domain Shift

不同資料集的遷移學習

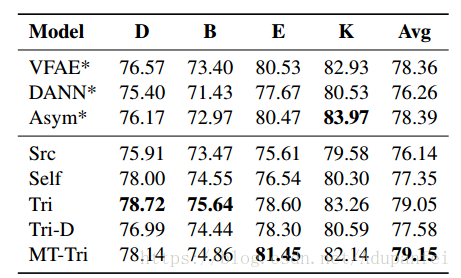

MT-Tri方法在情感分析上(無監督域適應)超過DANN方法

半監督學習結合了監督學習和無監督學習方法,能在有標籤但標籤不完整的資料中使用機器學習演算法。本文重點介紹半監督學習演算法中特殊演算法,它們能在未標記資料上生成代理標籤(proxy-label),並將其與已經標記好的資料共同使用。這些標籤是模型本身或其變體生成的,無需額外監督——這意味著它們可能並不能反映事實,是嘈雜的、微弱的,但我們還是能從中提取到一些有用的學習訊號。

a) self-training (Self);

b) tri-training (Tri);

c) tri-training with disagreement (Tri-D); and

d) asymmetric tri-training (Saito et al., 2017).

e) MT-Tri

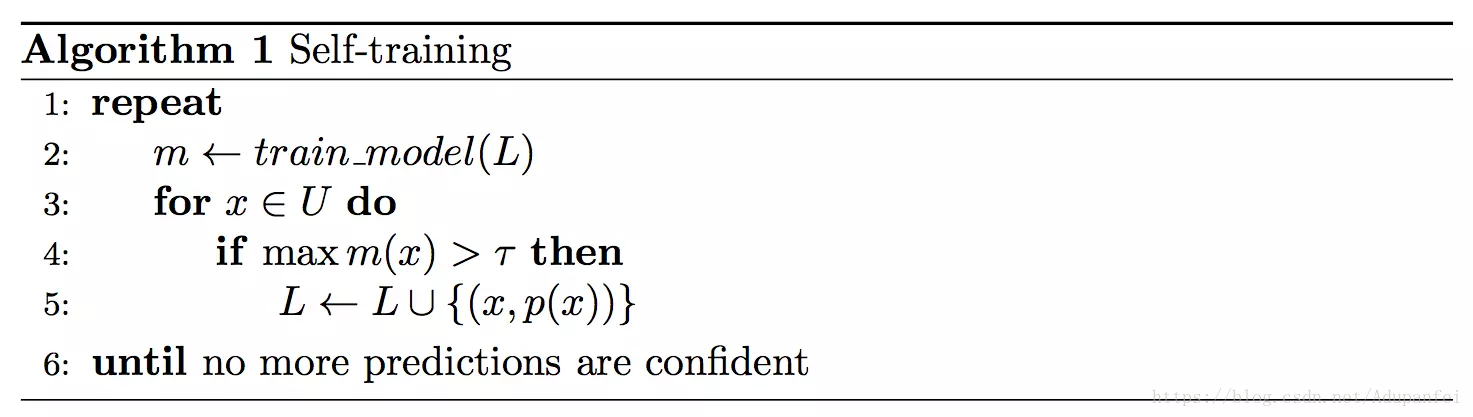

Self-training(自訓練演算法)

Self-training有一個模型m、一個含標籤訓練資料集L和一個不含標籤資料集U。每次迭代中,模型m會基於標籤集C,為U中的樣本x生成一個標籤概率m(x)。如果m(x)大於閾值τ,我們就用p(x)=argmax m(x)為樣本x生成一個偽標籤(pseudo-label),然後把它歸入訓練集L中。

這個過程通常要重複固定次數的迭代,直到為所有“沒有把握”的樣本確定一個靠譜的偽標籤。

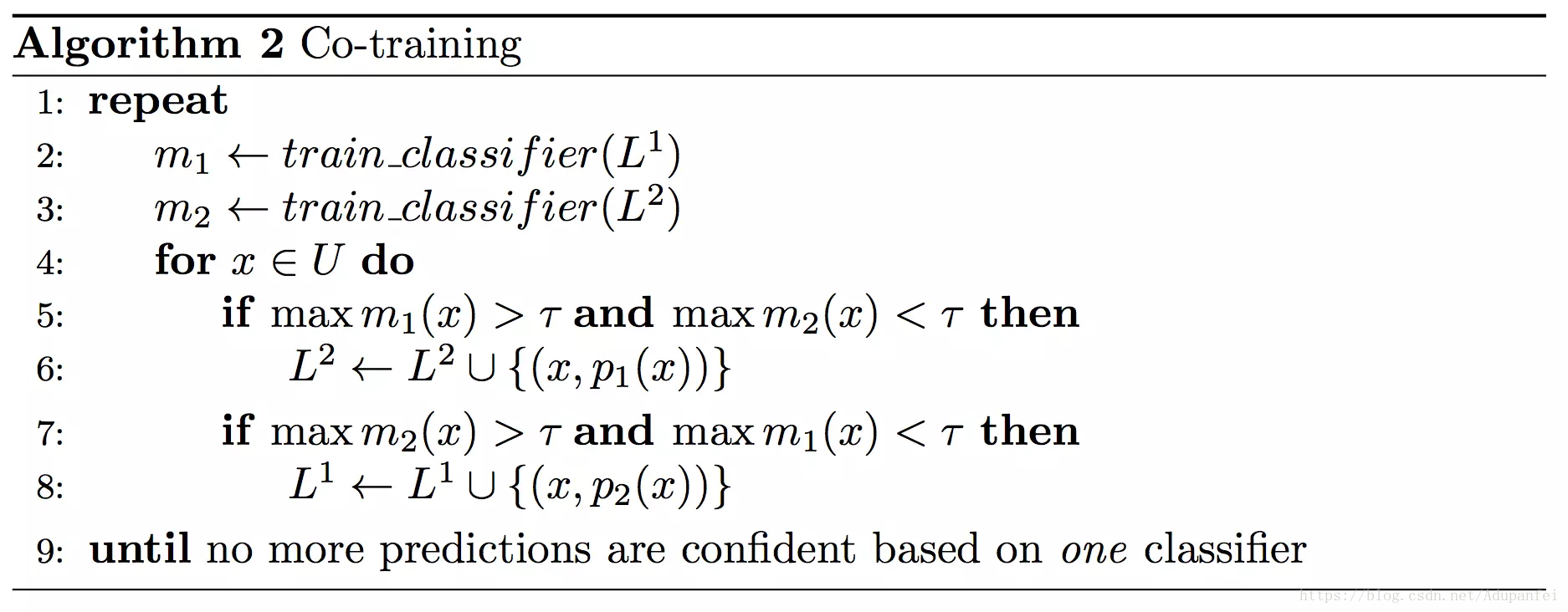

Co-training(協同訓練)

Co-training有m1和m2兩個模型,它們分別在不同的特徵集上訓練。每輪迭代中,如果兩個模型裡的一個,比如模型m1認為自己對樣本x的分類是可信的,置信度高,分類概率大於閾值τ,那m1會為它生成偽標籤,然後把它放入m2的訓練集。簡而言之,一個模型會為另一個模型的輸入提供標籤。以下是它的虛擬碼:

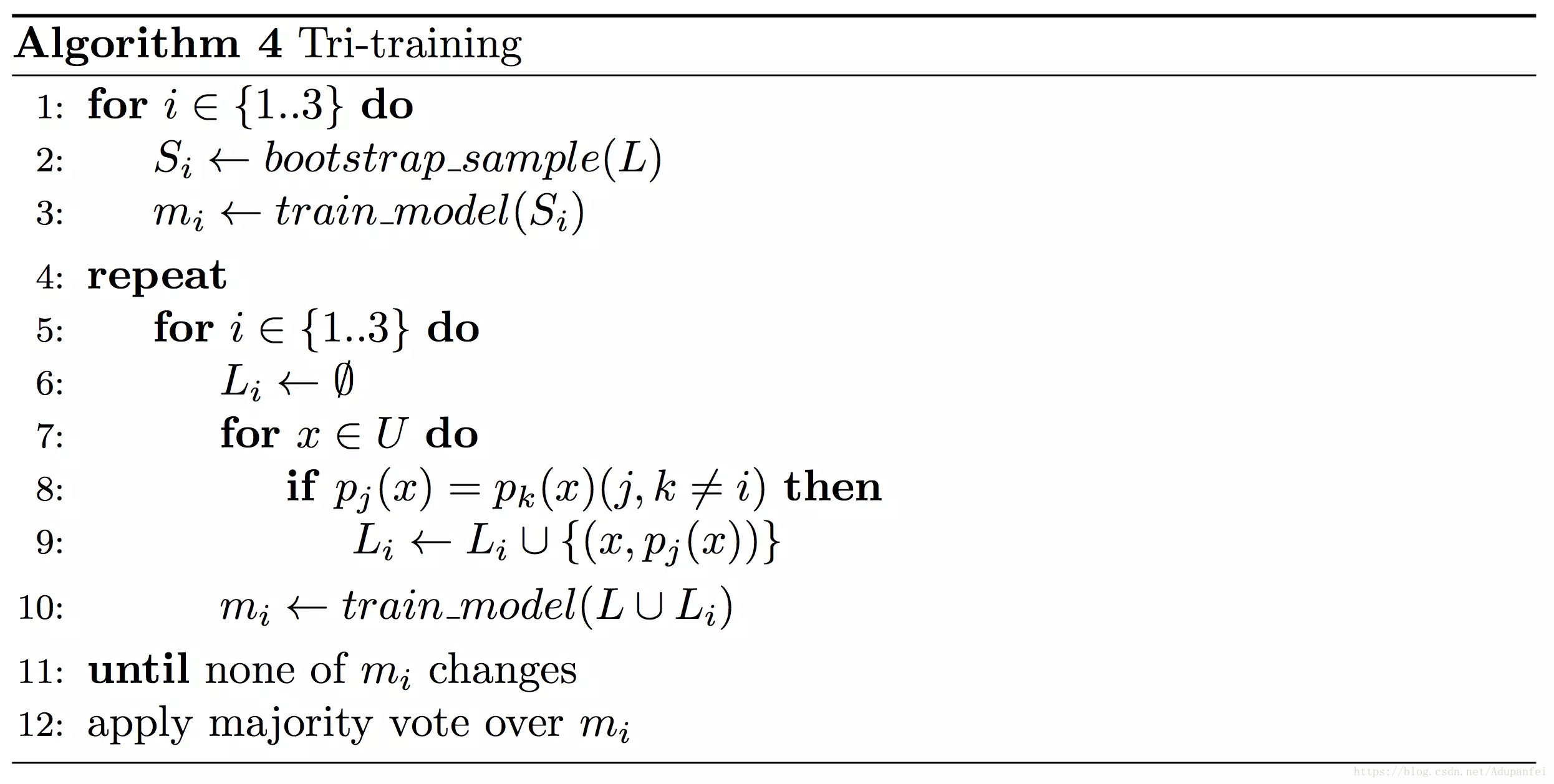

Tri-training(三體訓練法)

在取樣變體上分別訓練出m1、m2、m3三個模型後,它們無需計算置信度,只需按照“少數服從多數”的做法篩選出標籤。選擇兩個模型m1,m2都agree的label,並且m3 disagree的label,將此樣本加入m3的訓練集中。那麼演算法會為樣本生成多數同意的偽標籤,然後把它放入mi的訓練集。

Tri-training with disagreement

Asymmetric tri-training

Asymmetric tri-training讓三個模型中的一個只在代理標籤上訓練,而不是已有標籤集(演算法4中的第10行),並且這個模型只會在測試期間完全對目標域樣本進行分類。這就是它非對稱(Asymmetric)的原因——三個模型的作用是不一樣的。此外,三個模型使用的相同的特徵提取器。

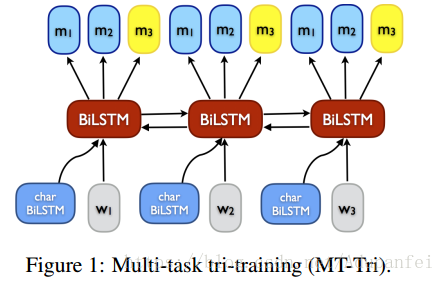

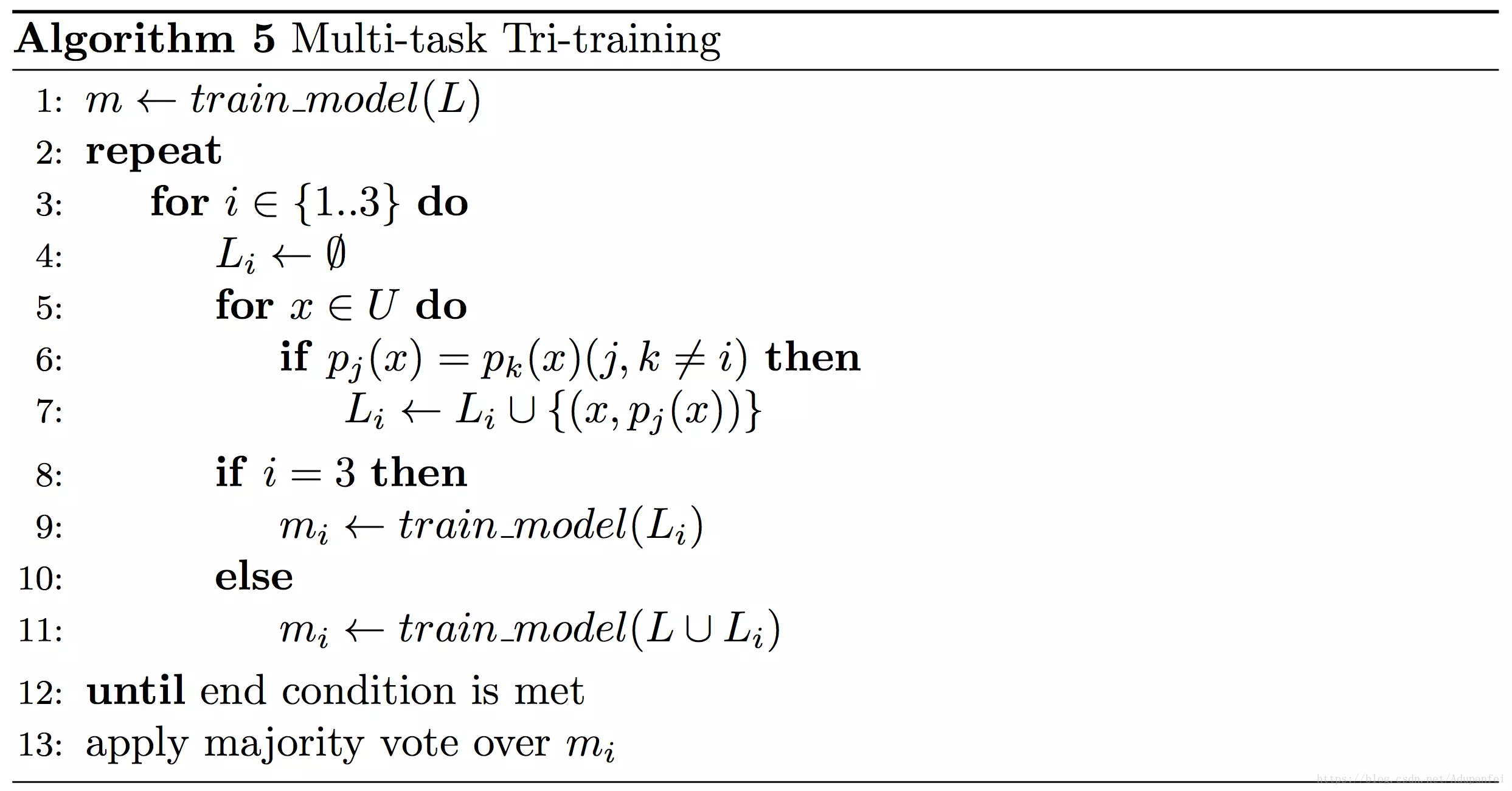

Multi-task tri-training

如果說Tri-training有什麼缺點,那應該就是它有三個獨立模型要訓練,所以必須依賴大量訓練資料,這在實踐中的代價昂貴的。為了緩解這一問題,2018年,Ruder和Plank把遷移學習思想引入半監督學習,提出Multi-task tri-training演算法[23],旨在減少三體訓練過程中的時間、空間複雜度,實現跨模型知識共享和加速訓練。正如Multi-task這個詞所顯示的,Multi-task tri-training不再單獨訓練模型,而是共享引數,並用多工學習(MTL)機制對它們進行聯合訓練。需要注意的是,這裡的三個模型還是作用相同的,所以這只是個偽MTL。

如下圖虛擬碼所示,和經典Tri-training演算法相比,Multi-task tri-training可以聯合訓練多工模型及其三個特定模型的輸出,而且因為正交約束強制模型m1和m2之間的不同表示,演算法不用對帶標籤的源域資料進行bootstrap取樣直至收斂。第三個模型m3只在生成了偽標籤的目標樣本上訓練,最後演算法會依據“多數投票”機制決定最終預測結果。

附:Self-ensembling

Ladder networks

Virtual Adversarial Training

Π model

Temporal Ensembling

Mean Teacher