線性代數-總結(一)

線性代數的核心內容就是線性變換,前面主要從靜態和動態兩個方面進行描述,奇異值分解應該比矩陣對角化更為一般,矩陣對角化只是它的特殊情況而已,而對稱矩陣更是特殊的存在。到目前為止個人認為只是通過“線性代數及其應用一書”把線性變換的主要內容給講明瞭,還有很多方面未提及。總結內容如下:

1、向量本身是一個有大小和方向的量,因此向量可以自由的平移。為了研究的方便通常把向量放到一個座標系中進行研究,座標就是一個點的位置,0座標就是所有向量的起始點,由於向量是兩點連線的方向和位移,因此從0座標出發到該向量值表示座標的連線代表該向量。

2、有了座標系後,我們知道在不同的座標系中同一向量的座標值也不同。而且我們對向量的研究一定要放在某個特定的座標系中,如果不作特殊說明一般預設座標系為單位矩陣。

3、座標系也叫做基,基必須由線性無關的向量構成,基向量的線性組合張成了空間。相同的空間可以有無數的基,為了研究方便經常用標準正交基(單位矩陣就是特殊的標準正交基,標準正交基同樣是無數個)。空間中包含無數個經過0座標的子空間(必須要過0座標)。線性無關向量的個數為空間的維數(維數相同不代表空間相同,比如三維中的平面和二維平面不是同一個空間)。

4、矩陣是由多個向量構成的,如果向量線性無關那麼矩陣可以看作空間的基,如果線性相關那麼矩陣中某個向量可以被其餘向量表示則該空間一定是子空間。向量X可以表示成矩陣A*座標X`,向量X也可以表示成矩陣A中各個向量的線性組合,組合的權重可以表示成向量X`。

令X=A.X1=B.X2,X1和X2分別表示向量X在基A和B下的座標。X1=A-1.B.X2或者X2=B-1.A.X1,令P=A-1.B則P-1=B-1.A,P又叫做基變換矩陣。

5、矩陣A還可以表示線性變換,此時向量X代表著某個固定物件並在某個基下有初始座標X1,然後通過A的作用後移動到座標X2的位置上,此時A相當於一個作用力並與基無關也就是脫離座標系的(例如線性變換A將向量拉伸2倍,在任何基下面它都將座標位置移動到初始位置2倍的座標處)。

6、矩陣A表示線性變換時是與基無關的,但一旦談及相似矩陣的時就與基相關了。它說的是同一線性變換在不同基下的表示方式(假設在你面前有一輛汽車從左向右飛馳而過,但對於你對面的人汽車是從他由右向左的方向行駛的,汽車的運動是固定的只是不同人觀察的視角不同),很明顯同一線性變換的相似矩陣有無數個。

7、矩陣A可以對向量拉伸或者旋轉甚至是拉伸與旋轉並存,而且還存在著拉伸最大、次大的幅度。為了更為一般的討論,矩陣A可以是方陣也可以是長方形矩陣,要找出這樣的幅度就需要在所有的座標向量中尋找,為了計算的方便:1、將所尋找的向量放在單位矩陣構成的基中討論;2、將座標向量設定為單位向量(假設某個單位向量具有最大的拉伸幅度,那麼該單位向量上所有的向量都有相同的拉伸幅度)。該問題可以描述為求解|AX|的最大、次大值,進一步轉換為在|X|=1下求解![]()

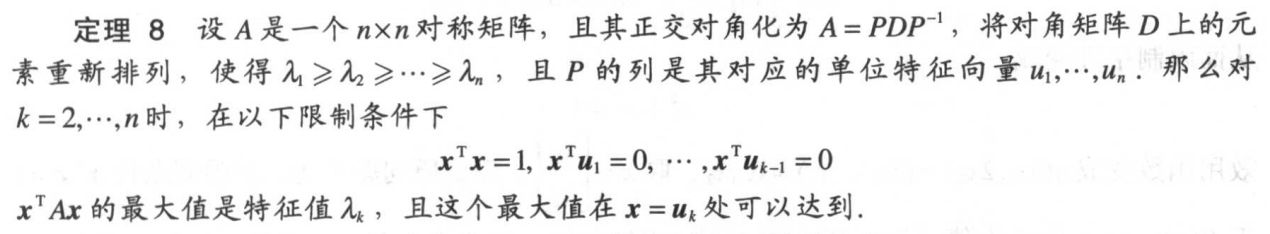

為對稱矩陣,根據

為對稱矩陣,根據

就可以求出相應的解。

8、根據第7點按照奇異值分解固定步驟就可以對所有矩陣進行分解,寫到這裡又出現蛋和雞的先後問題了:儘管奇異值分解可以分解所有矩陣應該比方陣對角化更具一般性,但是奇異值分解依賴於對稱矩陣的對角化更依賴於方陣的對角化,所以一般書籍都是按照方陣對角化、對稱矩陣和二次型最後才是奇異值分解的方式來說的,要是能將奇異值分解放在前面講就好了,因為個人傾向於從一般到特殊的思維方