虛擬機器ubuntu18.04環境下hadoop2.9和hive3.0安裝

一、基礎環境和下載

環境:ubuntu18,64位

虛擬機器:virtualbox5.2

下載hadoop2.9.1 https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/

下載jdk1.8.0 http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

下載hive3.0.0 https://mirrors.tuna.tsinghua.edu.cn/apache/hive/

二、建立HADOOP使用者

sudo useradd -m hadoop -s /bin/bash

設定密碼

sudo passwd hadoop

增加管理員許可權

sudo adduser hadoop sudo

三、更新軟體,安裝ssh

sudo apt-get update

sudo apt-get install vim

sudo apt-get install openssh-server

登陸本機:

ssh localhost

exit # 退出剛才的 ssh localhost

cd ~/.ssh/ # 若沒有該目錄,請先執行一次ssh localhost

ssh-keygen -t rsa # 會有提示,都按回車就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授權

四、安裝java,配置環境

tar -zxvf jdk-8u171-linux-x64.tar.gz配置環境變數sudo gedit /etc/profile末尾加上export JAVA_HOME=/usr/lib/jvm/jdk1.7.0_21 export CLASSPATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$CLASSPATH export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH 終端輸入source /etc/profile五、安裝hadoop

sudo tar -zxf hadoop-2.9.1.tar.gz -C /usr/local # 解壓到/usr/local中

定位到/usr/local

sudo mv ./hadoop-2.9.1/ ./hadoop # 將資料夾名改為hadoop

sudo chown -R hadoop ./hadoop # 修改檔案許可權

驗證是否安裝成功

cd /usr/local/hadoop

./bin/hadoop version

安裝成功會顯示版本

六、修改配置檔案

gedit ./etc/hadoop/core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>gedit ./etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>gedit ./etc/hadoop/hadoop-env.sh

修改java環境變數(你安裝的位置) export JAVA_HOME=/lib/jdk1.8.0_171

執行 NameNode 的格式化:

./bin/hdfs namenode -format

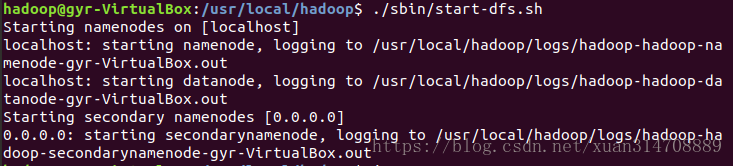

開啟 NameNode 和 DataNode 守護程序

./sbin/start-dfs.sh

啟動完成後,可以通過命令 jps 來判斷是否成功啟動

關閉命令sbin/stop-dfs.sh

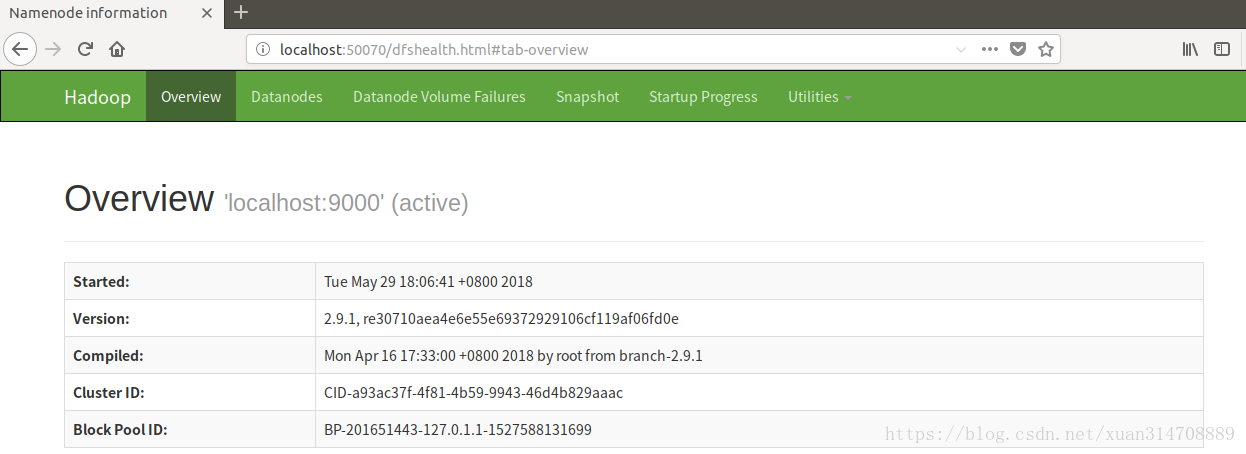

可以開啟http://localhost:50070/檢視 NameNode 和 Datanode 資訊,還可以線上檢視 HDFS 中的檔案。

七、安裝mysql

第一次安裝呼叫不出來mysql,所以決定解除安裝重安就可以了

sudo apt-get install mysql-server

sudo apt install mysql-client

sudo apt install libmysqlclient-dev

先清除之前的安裝資訊

sudo apt-get autoremove --purge mysql-server-5.0

sudo apt-get remove mysql-server

sudo apt-get autoremove mysql-server

sudo apt-get remove mysql-common

清理殘留資料

dpkg -l |grep ^rc|awk '{print $2}' |sudo xargs dpkg -P

再次安裝

sudo apt-get install mysql-server

sudo apt-get install mysql-client設定mysql允許遠端訪問終端輸入sudo gedit /etc/mysql/mysql.conf.d/mysqld.cnf

註釋掉bind-address = 127.0.0.1

在mysql中輸入

grant all on *.* to [email protected]'%' identified by '你的密碼' with grant option;

flush privileges;

在終端中重啟mysql

service mysql restart

八、複製這個ubuntu系統

右擊ubuntu,選擇“複製”,選擇初始化mac地址,確定,“完全複製”,複製出兩個新的ubuntu系統,命名為ubuntu2和ubuntu3

九、更改ubuntu2和ubuntu3的IP地址

複製出來的虛擬機器IP地址是重複的,需要修改

在/etc/netplan中找到字尾名為.yaml的檔案,開啟終端

sudo gedit 01-network-manager-all.yaml

network:

ethernets:

enp0s3:

addresses:

- 192.168.0.2/20

gateway4: 192.168.12.2

nameservers:

addresses:

- 223.5.5.5

search: []

optional: true

version: 2儲存退出,在終端中輸入:sudo netplan apply,使之生效

在終端中輸入ifconfig可檢視ip

三個虛擬機器的ip分別是192.168.0.1,192.168.0.2,192.168.0.3

十、修改3個系統的主機名字

檢視當前主機的主機名稱:sudo /bin/hostname

設定當前主機的主機名稱:sudo /bin/hostname newname

三個主機名字分別是master,slave1,slave2

定位到/etc,開啟終端sudo gedit hosts

192.168.0.1 master

192.168.0.2 slave1

192.168.0.3 slave2

手動重啟網路服務生效:sudo /etc/init.d/networking restart

十一、

十二、

參考:http://www.powerxing.com/install-hadoop/

相關推薦

虛擬機器ubuntu18.04環境下hadoop2.9和hive3.0安裝

一、基礎環境和下載環境:ubuntu18,64位虛擬機器:virtualbox5.2下載hadoop2.9.1 https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/下載jdk1.8.0 http://www.or

虛擬機器Ubuntu18.04 root下 連線 windows 中 winScp

先檢視自己虛擬機器中是否有 ssh服務 如果沒有的話先安裝 apt-get install openssh-server 安裝完之後 先手動開啟一下服務 /etc/init.d/ssh restart 檢視ssh的服務埠

ubuntu18.04環境下hadoop3.1,spark虛擬機器分散式安裝筆記

環境:Ubuntu18.04 LTS系統虛擬機器:選擇的是Virtul Box,佔用資源比較少 安裝三個虛擬機器,主機名分別是:master、slave01、slave02,使用者名稱都設定為hadoop設定網路,橋接模式,可以實現區域網訪問系統安裝完畢後,更新系統,sudo

Ubuntu18.04環境下設定虛擬網絡卡

輸入命令:ipconfig進行檢視: 然後,進行新增命令: sudo gedit /etc/network/interfaces 在檔案中新增: auto enp8s0:1 iface

Ubuntu18.04 環境下g++ 中出現error: stray ‘\357’ in program問題

環境: 程式設計環境:Ubuntu18.04 程式設計工具:vim 編譯工具:g++ 輸入法:搜狗 錯誤: 編譯報錯:error: stray '\357' in program 原因:在程式中打入了全形字元 具體分析產生原因: 在程式設計中,由於打字的快速,按下

安裝UBUNTU18.04環境下的OpenCV3.4.1

安裝 cmake -D CMAKE_BUILD_TYPE=RELEASE -D CMAKE_INSTALL_PREFIX=/usr/local -D INSTALL_PYTHON_EXAMPLES=OFF -D INSTALL_C_EXAMPLES=OFF

ubuntu18.04環境下編譯安裝opencv3.4

ubuntu18.04由於出來沒多久,很多應用也沒有很快就適配,而且由於系統配置環境的不熟悉,經常會出現一些不可預知的錯誤。下面記錄的是我電腦上安裝opencv3.4.0的安裝過程,網上這類教程很多,但是由於自己安裝過程中出現了幾個自己無法找到的問題,所以還是想記錄一下。

Ubuntu18.04環境下melodic安裝gmapping

odi col 很多 cnblogs www. 解決 可能 geo https Ubuntu18.04 環境下melodic中很多包沒有提供sudo apt install的安裝方式,需要通過源代碼安裝,安裝方法如下: 1、先安裝依賴庫: sudo apt-get

ubuntu13.04 環境下中谷歌chromium中安裝Adobe Flsher Player 外掛

1 背景介紹 在使用chromimu瀏覽瀏覽器時,會出現播放不了網頁上的視訊的情況,原因是沒有安裝Adobe Flsher Player 外掛,這時網頁的搜尋欄的下部會提示使用者是否安裝Adobe Flsher Player 外掛,點選安裝外掛,會調轉到Adobe Flsher Player

Ubuntu 14.04 64bit下Caffe + Cuda6.5/Cuda7.0 安裝配置教程

-a att html mode .net share surface art cores http://www.embeddedlinux.org.cn/emb-linux/entry-level/201612/21-6005.html 隨著深度學習快速發展的浪潮,許多有

mac環境下,python2和python3同時安裝

1、mac本身自帶一個python2 可以通過which is python,檢視python的安裝目錄 通過環境變數echo $PATH 檢視自帶python的執行目錄 環境變數的載入順序/etc/profile /etc/paths ~/.ba

ubuntu18.04.1下配置前端開發環境(nvm),nvm安裝不成功的解決辦法

# Proxy alias setproxy="export ALL_PROXY=socks5://60.205.84.96:10086" alias unsetproxy="unset ALL_PROXY" 寫到 ~/.bashrc 最後面 然後,退出當前的 terminator 再開

虛擬機器VMware Workstation Pro下安裝ubuntu-14.04.4(64位)方法(附ubuntu-14.04-desktop-amd64.iso下載連結)

ubuntu-14.04-desktop-amd64.iso下載: 連結:http://pan.baidu.com/s/1bFi0d4 密碼:yx0l 零基礎linux使用入門教學視訊分享: 連結:http://pan.baidu.com/s/1kU4GKWB 密碼

VMware 下Hadoop叢集環境搭建之虛擬機器克隆,Hadoop環境配置

在上一篇我們完成了ContOS網路配置以及JDK的安裝,這一篇將在上一篇的基礎上繼續講解虛擬機器的克隆,hadoop環境搭建 虛擬機器克隆. 利用上一篇已經完成網路配置和jdk安裝的虛擬機器在克隆兩臺虛擬機器. 1. 將擬機hadoop01關機.

Ubuntu16.04環境下Python下xlearn機器學習庫的配置

一、xlearn的簡介參見:https://www.zhihu.com/question/37256015/answer/268151326,http://www.sohu.com/a/206728248_206784 在機器學習裡,除了深度學習和樹模型 (GB

windows下使用虛擬機器搭建linux環境

一、前期工作:需要下載的軟體 直接在百度軟體中心下一個VMware即可 二、安裝教程 安裝路上踩得坑,首先在安裝VMware程式時,一開始就報錯: 解決辦法如下: 出現這個介面,不要點結

Ubuntu16.04環境下Python下Lightgbm機器學習庫的配置

一、Lightgbm簡介 xgboost的出現,讓調參俠們告別了傳統的機器學習演算法們:RF、GBM、SVM、LASSO等等,而微軟推出了一個新的boosting框架Lightgbm更是向前進一步,漸漸有取代的xgboost這一開源框架地位的趨勢。相比於xgboost,L

虛擬機ubuntu14.04環境搭建記錄

apt com 解決方法 虛擬機 環境 使用 start date class 之前搭建過的虛擬機,沒記錄,這次換了新電腦順便記錄下來。 一、虛擬機搭建好之後,發現虛擬機ssh無法使用 解決方法:apt-get update 更新源地址 apt-get in

虛擬機 Ubuntu18.04 tensorflow cpu 版本

http 虛擬機 style 設置 不存在 vgg 正常 div 都是 虛擬機 Ubuntu18.04 tensorflow cpu 版本 虛擬機VMware 配置: 20G容量,可擴充 2G內存,可擴充 網絡采用NAT模式 平臺:win10下的Ubuntu18.04

解決xshell無法連接virtualbox中的虛擬機(Ubuntu18.04)的問題

實現 dhcp nat 退出 兩張 無法連接 遇到 cmd box 遇到這個問題第一反應是是否安裝相應的組件: sudo apt-get install openssh-server 開啟防火墻端口 firewall-cmd --zone=public --add-p