【翻譯】Visual Place Recognition_ A Survey視覺場景識別綜述【二】

3 什麼是地點?

機器人學中地點的概念出自機器人導航和建圖。實際的機器人感測器和致動器是會出錯的,所以構建一個度量準確的世界地圖,並用來自定位是具有挑戰性的。而這兩個目標的結合,稱為SLAM [37] - [41],更難實現。

相對於維護一個精確的度量地圖,替代方法是維護一個“關係地圖,其具有彈性和可擴充套件性的,而不是在一個2D座標系”(見[40])。這樣的拓撲地圖在概念上類似於生物學中的認知圖。節點表示世界中可能的地點,邊表示這些地點之間可能的路徑。機器人導航可以抽象地定義為沿著節點之間的邊走。地點表示路線之間的關鍵交叉點、決策點[42],[43]或最終目標點。

這種拓撲導航方法在實踐中也有困難。機器人必須將抽象路線和地點與實際物理位置和路徑相關聯,並且需要理清機器人感測器資料,機器人控制訊號以及機器人對世界的拓撲度量描述之間的複雜關係[26]。另一個問題是機器人如何生成拓撲地圖。如果機器人可以獲取環境的度量柵格地圖,那它可以從中提取拓撲資訊,並突出相關的導航資訊,如開放的空間和通道[44]。或者,機器人也可以通過視覺資料及其處理後的資訊建立拓撲圖。

地點的定義取決於導航背景,它可以是一個精確的位置——“一個地方,將環境的一部分描述為零維點”(見[26]),或一個更大的區域——“一個區域的抽象”,這裡的一個區域“代表環境的一個二維子集”(見[26])。例如,建築物中的一個房間,在某些情況下,可能是一個地點,而在其他情況下,它也可能包含許多不同的地點。根據環境或機器人的需求,一個地點也可以是三維的。與機器人位姿不同,地點不具有方向性,並且場景識別中的一個長期挑戰是姿態無關性——確保機器人在地點內任意方向上都能識別出來。

無論是一維點還是更大的區域,每個地點的位置都可以基於空間或時間密度來確定。在該方法中,根據特定的時間步長,或者,當機器人行進了一定距離時新增新地點。一個地方可以根據其外觀定義。Kuipers和Byun [25]根據地點標籤或地點描述來定義地點。雖然拓撲地圖沒有固定的標準,但是要具有特定的外觀形態[45],[46],外觀變化顯著時要有一個物理邊界,稱為“衝要”[47]。

具有視覺相似性的拓撲區域需要被量化——也就是說,場景識別系統如何將環境分割成不同的地方?Ranganathan[48]指出,它與視訊分割中的變化點檢測有相似之處[49],[50],Ranganathan使用變化點檢測演算法,如Bayesian surprise[50]和分割回歸[51] 來定義拓撲圖中的地點[48],[52]。感測器測量環境的外觀,當它與當前環境模型差異較大時,建立新的地點。類似地,Korrapati等使用影象排序分割技術將視覺上相似的影象歸類為拓撲圖節點,而Chapoulie等人 [54]使用了Kalman濾波與Neyman-PearsonLemma結合的方法來完成這一步驟。Murphy和Sibley [55]結合動態詞彙構建[56]和增量式主題建模[57],不斷地學習環境中新的拓撲區域,Volkov等人 [58]使用coresets [59]來分割環境。主題建模,coresets和Bayesian surprise的技術也可用於機器人導航的其他方面,比如,總結機器人已有的經驗[ 60 ]–[ 62 ],或確定勘探策略[ 63 ]。

外觀和密度,如距離,時間,或感測器值[ 64 ],為可測量的量,所以,基於外觀和密度的地點選擇方法比較實用。使用諸如“門”或“路口”的語義標籤來增強外觀資訊,雖然比較有挑戰性,但是這樣它們可以基於決策點的資料線上匹配地點。地圖中語義資料的新增有利於規劃和導航[65],它要求場景識別與其他識別和分類任務相關聯,特別是場景分類和物體識別。他們的關係是相互的:場景識別可以為物體檢測提供標檢測的情境以及物體位置的先驗資訊,從而改善物體檢測[66],反過來,物體識別也有利於場景識別[67] - [70],特別是室內環境,我們可以從室內的東西來判斷它的用途,比如“廚房”或“辦公室”,然後結合語義標籤地圖來定位[71]。

4 地點描述:影象處理模組

基於視覺的地點描述技術分為兩大類:一類是選擇性地提取一些有意義的影象部分;另一類是無選擇性地描述整個場景。區域性特徵描述子屬於第一類,例如尺度不變特徵(SIFT)[72]和加速魯棒特徵(SURF)[73]。區域性特徵描述子首先要檢測影象中的區域性特徵[見圖 4(a)]。而全域性影象描述子,如Gist [74],[75]沒有檢測階段,但需要處理整張影象[見圖4(b)]。

A.區域性特徵描述子

SIFT [72]在場景識別中應用廣泛 [76] - [83]。隨著技術的發展,其他區域性特徵檢測和描述方法也用於視覺定位和場景識別問題中。例如,Ho和Newman [84]使用了Harris affine regions[85],Murillo等人 [86]和Cummins與Newman[87]使用了SURF [73],而FrameSLAM [2]使用了CenSurE [88]。區域性特徵提取包含特徵檢測與描述子提取兩個步驟,每個步驟可以使用不同的技術。例如,Mei等人 [89]使用FAST檢測方法 [90]來找到影象中的關鍵點,然後通過SIFT描述子進行描述。類似地,Churchill and Newman [15]使用FAST提取,再用BRIEF [91]描述。

[圖4 基於視覺的地點描述技術分為兩大類。(a)選擇影象中感興趣或突出的部分用來提取,描述和儲存。例如,SURF [73|提取並描述影象中的興趣點。圓圈中是該影象內的SURF選擇的興趣點。特徵的數量取決於影象中檢測到的感興趣點。(b)以預定方式描述影象,例如這裡的網格,而不是先檢測興趣點。全影象描述子,如Gist [74|,75| 不管圖片內容,直接處理每個塊。

每張影象都包含數百個區域性特徵,所以直接匹配影象特徵效率很低。詞袋模型[92] [93]通過量化區域性特徵,使其變為檢索詞彙 [94]來提高效率。詞袋模型將特徵空間(例如SIFT或SURF描述子)分成視覺詞彙。一般詞彙量為5000–10000字,但FAB-MAP 2的詞彙量有100000個[ 87]。影象中的每個特徵點為一個特定的詞,然後忽略幾何或空間結構,將影象壓縮到二進位制串或長度為n的直方圖,其中n是詞庫中的單詞數量。

對於bag-of-words描述的影象,使用二進位制串匹配(如漢明距離或直方圖對比技術)效果較好。詞彙樹[95]可以提高大規模場景識別的效率。詞彙樹是針對目標識別提出的,通過分層模型來定義詞,建立更大的和易分辨的詞彙庫,提高了查詢視覺詞彙的速度。使用bag-of-words方法的定位系統包括[82],[84],[87],[96],[97]等等。

因為bag-of-words忽略了地點的幾何結構,所以該方法的地點描述具有姿態無關性,即,無論機器人在該地點內的位置如何,都能夠識別。然而,向地點描述中新增幾何資訊可以提高匹配的魯棒性,尤其是在動態環境中[14],[87],[98] - [100]。這些系統能夠通過鐳射感測器獲取3D資訊[98],再使用立體視覺[14],對極約束[100],[101]或者影象內元素的位置來定義場景幾何[102],[103]。姿態無關性(場景識別與機器人方向無關)以及環境無關性(外觀資訊變化時的場景識別)問題還有待解決,這也是當前位置識別研究領域中的一大挑戰。

我們可以從訓練影象序列中提取特徵,來預定義Bag-of-words模型。但該方法具有侷限性,因為所得到的模型依賴於環境,如果機器人移動到新的區域,則需要重新訓練。Nicosevici和Garcia [56]提出了一種線上方法,根據觀測結果不斷更新詞彙,同時仍然能與已有的觀測資訊進行匹配。因此, bag-of-words不需要預訓練階段也能適應環境,而且效果優於預訓練模型[56]。

B. 全域性描述子

早期定位系統中使用的全域性地點描述子包括顏色直方圖[5]和主成分分析 [104]。Lamon等人 [105]使用各種影象特徵,如邊緣[106],角[107]和色塊組合成位置指紋。特徵在0°和360°之間順序排列,可以將位置識別簡化成字串匹配。系統使用全景相機,所以每個地點的匹配具有旋轉不變性。

在區域性圖片(比如影象中劃分出的網格)上找出關鍵點,然後描述其區域性特徵,這些區域性特徵描述子結合起來,形成全域性描述子。Badino等人[108]使用WI-SURF(SURF特徵)全域性影象描述子來定位,BRIEF-Gist(RIEF特徵) [109]也是類似的全域性影象方式。

Gist全域性影象描述子 [74],[75] 比較流行,已用於很多場合的場景識別[110] - [113]。Gist使用Gabor濾波器,以不同的方向和頻率,從影象中提取資訊,將結果平均,產生一個簡潔向量,表示場景的“依據”。

[圖 5似物性取樣(object proposal)方法,如此處所示的Edge Boxes法[123|用於目標檢測,也可用於識別潛在的地標。上面影象中的方框表示在一個場景中兩個視點(來自122|)之間,正確匹配的地標

C. 基於區域性和全域性技術的描述地點

區域性和全域性描述子各有優缺點。區域性特徵不僅可以定義與先前機器人姿態相關的地點,也可以重新組合來建立未被明確觀測的地點。例如,Mei等人 [114]通過covisibility定義地點:系統在地標covisibility map(共檢視)中定義cliques(各種區域性特徵點結合在一起形成一個團體),即使當前圖片中沒有地標,通過 cliques也能進行場景識別。Covisibility技術優於一般的影象處理技術[78]。Lynen 等人[115]建立二維描述子投票空間,其中高投票密度的區域表示候選閉環。

區域性特徵與度量資訊結合可以對定位進行度量修正[2],[7],[76]。全域性描述子沒有此功能,此外,在機器人的姿態改變時,整體影象描述子比區域性描述子更易發生變化,整體影象描述方法傾向於假定相機視點相似。迴圈移位[116]或詞袋方法,與影象塊上的Gist結合[17],[110]可以改善該問題。

雖然全域性描述相比於區域性特徵描述更具有姿態依賴性,但是當光照條件改變時,區域性描述子的特徵表現變差[117],在變化條件下執行場景識別時,全域性描述子的效能更勝一籌[118] [119]。在影象塊上使用全域性描述子可以折中兩種方法,足夠大的影象塊表現出整體影象的條件不變性,而足夠小的影象塊表現出區域性特徵的姿態不變性。McManus 等人 [120]在影象塊上使用HOG [121]來學習條件不變性的場景特徵,而Sünderhauf等人 [122]使用Edge Boxes似物性取樣方法結合中級卷積神經網路(CNN)特徵[124][123]來識別和提取圖5所示的地標。

D.地點描述子中的三維資訊

上述影象處理技術是基於環境外觀的 ——它們“直接在視覺域中對資料建模(而不是建立幾何模型)”(見[104])。然而,在度量定位系統中,外觀模型必須根據度量資訊進行擴充套件。單目影象資料不能直接提供幾何地標——“與鐳射資料不同,不能從影象中獲取世界幾何資訊(見[125])。許多系統使用附加感測器資料(如鐳射器[98]或RGB-D相機[126] - [128]),或者從常規相機計算出的幾何資料,來判斷機器人姿態。

度量距離可以使用立體相機採集的圖片來計算[2],[129] - [131]。單目攝像機還可以使用SFM演算法[132]來推斷尺度資訊。其他方法還包括MonoSLAM [7],PTAM [133],DTAM [134],LSD-SLAM [135]和ORB-SLAM [136]。度量資訊可能是稀疏的:也就是說,測量距離與區域性特徵有關,如MonoSLAM [7]中的影象塊,如[76]中的SIFT特徵,FrameSLAM [2]中的CenSurE特徵以及在ORB-SLAM [136]中的ORB特徵[137]。相反,DTAM儲存所有畫素的度量資訊(稠密),LSD-SLAM從包含結構和資訊的影象塊上提取深度資料(半稠密)。通過稠密度量資料,機器人可以避障、資料規劃建圖和定位,因此,可以自主視覺導航[16]。

通過新型感測器,如RGB-D相機,檢測深度資訊和影象資料,促進了稠密地圖技術的發展[70],[126] - [128],[138],[139] 。這些感測器還可以利用3D資訊來改善位置識別。SLAM ++ [70]儲存一個3D模型資料庫,在導航期間,使用該資料庫進行物體識別,並用識別出的物體作為地點的高階特徵。物體資訊相對於低級別地點特徵有以下優點:它們提供豐富的語義資訊,通過語義壓縮減少記憶體需求——在地圖中儲存物體標籤而不是完整的物體模型[70]。

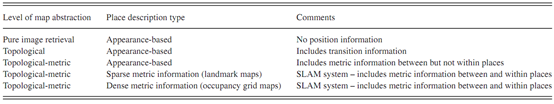

表 I 視覺場景識別的地圖框架