使用 liavformat 和 libavcodec 實現解碼器

阿新 • • 發佈:2018-11-25

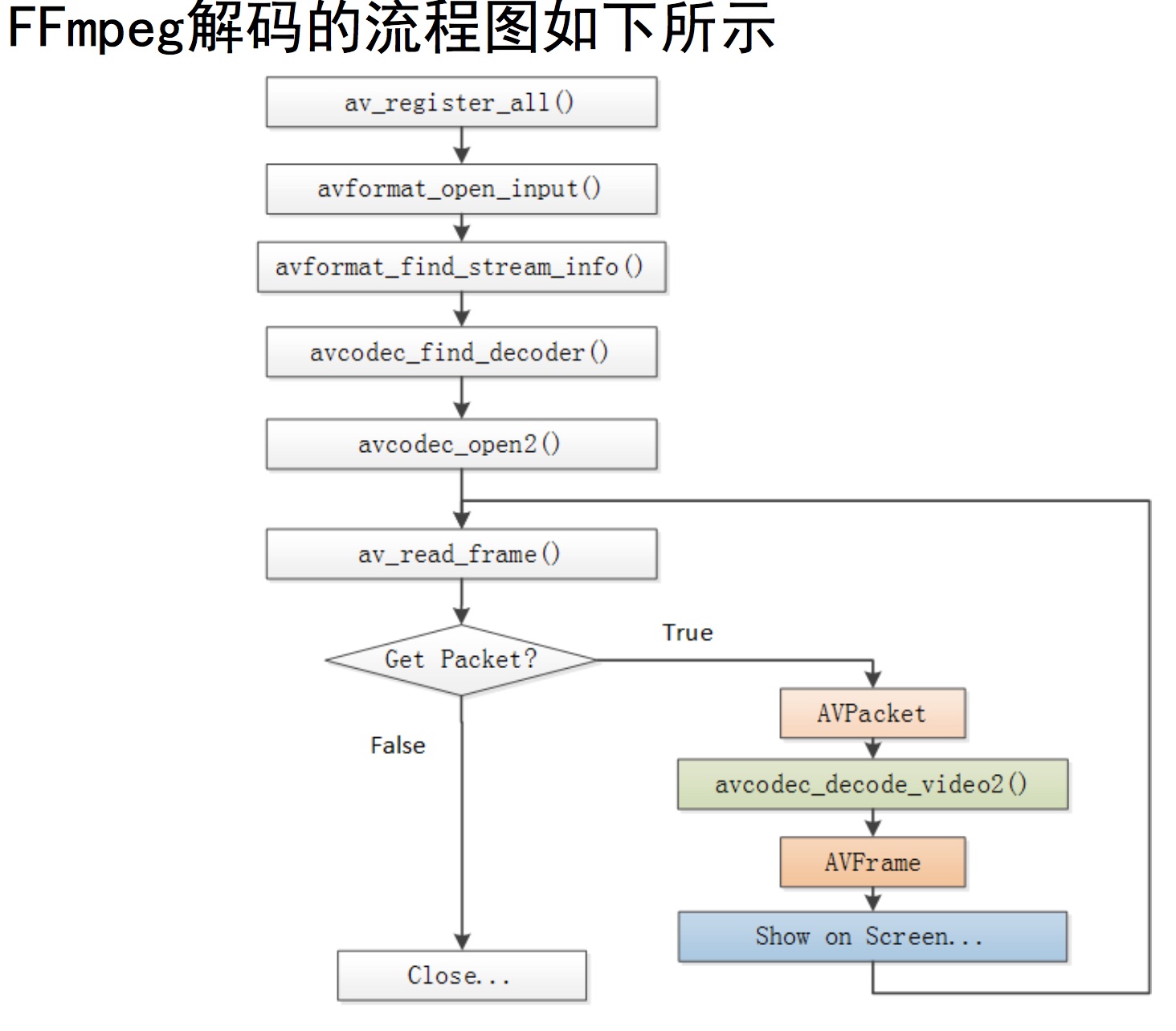

使用ffmpeg 的liavformat 解封裝,使用libavcodec 解codec,實現一個簡單的解碼器。

解碼的流程,從資料結構上看就是AVFormatContext ->AVCodecContext -> AVPacket -> AVFrame。 生成AVPacket 為解封裝,生成AVFrame 為解codec。其中,AVFormatContext:封裝格式上下文結構體,也是統領全域性的結構體,儲存了視訊檔案 封裝 格式相關資訊;AVCodecContext:編碼器上下文結構體,儲存了視訊(音訊)編解碼相關資訊;AVPacket:儲存一幀壓縮編碼資料;AVFrame:儲存一幀解碼後像素(取樣)資料。

生成AVFrame 後,可以使用sws 進行 不同 AVFrame 的轉換,比如將yuv420 轉成 rgb。其中,sws 的api 主要有3個,分別是:

- sws_getContext()

- sws_scale()

- sws_freeContext()

這裡,sws_getContext 對應的是初始化,sws_scale 對應的是轉換,sws_freeContext 是釋放函式。這裡特別強調下sws_scale 函式的用法:

int sws_scale(SwsContext *c, uint8_t* src[], int srcStride[], int srcSliceY, int srcSliceH, uint8_t* dst[], int dstStride[]) 七個引數: 第一個引數即是由 sws_getContext 所取得的引數。 第二個 src 及第六個 dst 分別指向input 和 output 的 buffer。 第三個 srcStride 及第七個 dstStride 分別指向 input 及 output 的 stride;姑且可以先把它看成是每一列的 byte 數。 第四個 srcSliceY,是指第一列要處理的位置。 第五個srcSliceH指的是 source slice 的高度。

知道上面流程後,能容易實現一個簡單的解碼器,解碼生成h264檔案和yuv 檔案。

下面是c 程式碼:

#include <stdio.h> #include <libavcodec/avcodec.h> #include <libavformat/avformat.h> #include <libswscale/swscale.h> //使用libformat & liavcodec 解碼 int main(int argc, char* argv[]) { AVFormatContext *pFormatCtx; int i, index; AVCodecContext *pCodecCtx; AVCodec *pCodec; AVFrame *pFrame,*pFrameYUV; uint8_t *out_buffer; AVPacket *packet; int y_size; int ret, got_picture; struct SwsContext *img_convert_ctx; // input & output init char *filepath = "input.flv"; FILE *fp_yuv=fopen("output.yuv","wb+"); FILE *fp_h264=fopen("output.h264","wb+"); // 註冊編碼解碼器 av_register_all(); // 初始化網路元件 avformat_network_init(); // 初始化 format pFormatCtx = avformat_alloc_context(); //開啟視訊流 if(avformat_open_input(&pFormatCtx,filepath,NULL,NULL)!=0){ printf("Couldn't open input stream.\n"); return -1; } // 尋找視訊流 if(avformat_find_stream_info(pFormatCtx,NULL)<0){ printf("Couldn't find stream information.\n"); return -1; } index = -1; for(i=0; i < pFormatCtx->nb_streams; i++){ if(pFormatCtx->streams[i]->codec->codec_type==AVMEDIA_TYPE_VIDEO){ index = i; break; } } if(index==-1){ printf("Didn't find a video stream.\n"); return -1; } // 獲取源視訊流的 codec pCodecCtx=pFormatCtx->streams[index]->codec; //查詢解碼器 pCodec=avcodec_find_decoder(pCodecCtx->codec_id); if(pCodec==NULL){ printf("Codec not found decodec.\n"); return -1; } //開啟解碼器 if(avcodec_open2(pCodecCtx, pCodec,NULL)<0){ printf("Could not open codec.\n"); return -1; } // 初始化AVFrame pFrame=av_frame_alloc(); pFrameYUV=av_frame_alloc(); out_buffer=(uint8_t *)av_malloc(avpicture_get_size(AV_PIX_FMT_YUV420P, pCodecCtx->width, pCodecCtx->height)); avpicture_fill((AVPicture *)pFrameYUV, out_buffer, AV_PIX_FMT_YUV420P, pCodecCtx->width, pCodecCtx->height); packet=(AVPacket *)av_malloc(sizeof(AVPacket)); //Output Info----------------------------- printf("--------------- File Information ----------------\n"); av_dump_format(pFormatCtx,0,filepath,0); printf("-------------------------------------------------\n"); // sws 初始化,設定源pixfmt 和目標pixfmt img_convert_ctx = sws_getContext(pCodecCtx->width, pCodecCtx->height, pCodecCtx->pix_fmt, pCodecCtx->width, pCodecCtx->height, AV_PIX_FMT_YUV420P, SWS_BICUBIC, NULL, NULL, NULL); while(av_read_frame(pFormatCtx, packet)>=0){//讀取一幀壓縮資料 if(packet->stream_index == index){ fwrite(packet->data,1,packet->size,fp_h264); //把H264資料寫入fp_h264檔案 ret = avcodec_decode_video2(pCodecCtx, pFrame, &got_picture, packet);//解碼一幀壓縮資料 if(ret < 0){ printf("Decode Error.\n"); return -1; } if(got_picture){ //PixelFormat 轉化,轉成yuv420 sws_scale(img_convert_ctx, (const uint8_t* const*)pFrame->data, pFrame->linesize, 0, pCodecCtx->height, pFrameYUV->data, pFrameYUV->linesize); y_size = pCodecCtx->width * pCodecCtx->height; fwrite(pFrameYUV->data[0],y_size,1,fp_yuv); //Y fwrite(pFrameYUV->data[1],y_size/4,1,fp_yuv); //U fwrite(pFrameYUV->data[2],y_size/4,1,fp_yuv); //V printf("Succeed to decode 1 frame!\n"); } } av_free_packet(packet); } sws_freeContext(img_convert_ctx); //關閉檔案,釋放記憶體 fclose(fp_yuv); fclose(fp_h264); av_frame_free(&pFrameYUV); av_frame_free(&pFrame); avcodec_close(pCodecCtx); avformat_close_input(&pFormatCtx); return 0; }

linux 上安裝ffmpeg 到/usr/lib 後,可以直接編譯使用:

gcc decoder.c -g -o decoder.out -I /usr/local/include -L /usr/local/lib -lavformat -lavcodec -lavutil -lswscale